INSIGHTS Stellungnahmen

Beitrag von Julian Gaberle, 04/06/2021

Letzten Monat unterzeichnete die Biden-Administration eine Executive Order mit der Absicht, Risiken für die Finanzstabilität zu reduzieren und die Offenlegung von klimabezogenen Risiken zu verbessern. Ein ähnliches Mandat wurde in Großbritannien unterzeichnet, wo Umwelt- und Klimaziele nun ausdrücklich von der Bank of England als Teil der Geldpolitik berücksichtigt werden.

Der folgende Beitrag zeigt, dass Systeme der Künstlichen Intelligenz (KI) das Potenzial haben, das Wirtschaftswachstum von steigenden Kohlenstoffemissionen und Umweltzerstörung zu entkoppeln. Aber welche Auswirkungen haben die KI-Systeme selbst auf das Erreichen einer klimaneutralen Wirtschaft?

KI-Systeme wurden bereits auf verschiedene Weise eingesetzt, um den CO2-Ausstoß zu reduzieren. Eine Methode ist der Einsatz von KI zur Ressourcenentkopplung (Verringerung des Ressourcenverbrauchs pro Einheit Wirtschaftsleistung), z. B. durch die Vorhersage von Ernteerträgen oder die Steuerung von Heizung und Kühlung der bebauten Umwelt. Zudem gibt es die Wirkungsentkopplung. Dabei werden wirtschaftlicher Output und Umweltbelastung durch den Einsatz intelligenterer Planungssysteme entkoppelt. Beispielsweise können KI-Systeme dazu beitragen, wirtschaftliche Emissionen zu reduzieren, indem sie den Energieverbrauch vorhersagen und so die Planung von erneuerbaren Energiequellen verbessern.

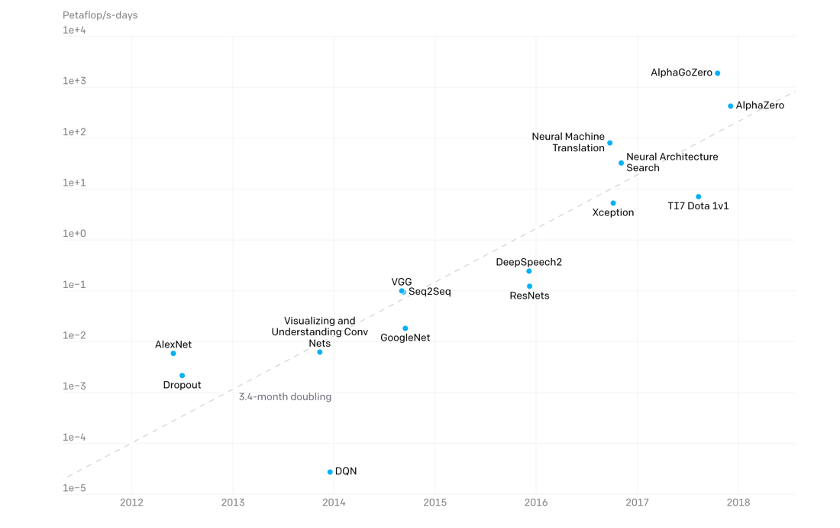

Abbildung 1: Veranschaulichung der Zunahme der Komplexität von KI-Modellen im Laufe der Zeit. (Quelle: https://openai.com/)

Trotz dieser Fortschritte haben KI-Anwendungsfälle für bahnbrechende Entwicklungen von „State of the Art“-Modellen erhebliche Berühmtheit erlangt, wie beispielsweise GPT-3, ein KI-Modell, das auf das Verstehen von Sprache trainiert wurde. Die für das Training eines einzelnen Modells benötigten Rechenressourcen sind in den letzten zehn Jahren exponentiell gestiegen (siehe Abb. 1). Eine einzige Trainingssitzung von GPT-3 verbraucht so viel Energie wie der Jahresverbrauch von 126 dänischen Haushalten.

Die Forschung und Entwicklung solcher Modelle über mehrere Architekturen und Hyperparameter steigert diese Kosten um ein Vielfaches. Die tatsächliche Zahl ist jedoch aufgrund mangelnder Offenlegung schwer zu schätzen. Darüber hinaus erfordern solche riesigen Modelle spezielle Datenspeicher und riesige Rechenanlagen, was den Zugang zu solchen Technologien auf wenige Technologieunternehmen beschränkt.

Gleichzeitig wird an effizienteren Modellen geforscht und bestehende Modelle werden kontinuierlich verbessert (siehe Abb. 2). Unter Verwendung bestehender Hardware können Verbesserungen bei der Datenverarbeitung, der Parallelverarbeitung und der Code-Effizienz erzielt werden. Aus der Hardware-Perspektive wird intensiv an kundenspezifischen Verarbeitungschips geforscht, wie z. B. die Wafer-Chips von Cerebras oder die TPUs von Google, die für bestimmte KI-Anwendungen optimiert sind. Sie können die für die Entwicklung und den Einsatz eines Modells erforderlichen Ressourcen reduzieren.

Abbildung 2: Modelleffizienz im Zeitverlauf. (Quelle: https://openai.com)

Mehrere Faktoren beeinflussen die Umweltauswirkungen von KI-Systemen: der Standort der für die Entwicklung verwendeten Rechenressourcen, die lokale Energieversorgung, die Größe des Datensatzes und die zum Trainieren der Modelle verwendete Hardware.

Noch vor 10 Jahren wurden 79 % der Rechenleistung in kleineren Rechenzentren und Unternehmensservern erbracht. Seitdem hat jedoch eine dramatische Verlagerung in die Cloud stattgefunden. 2018 schätzte ein Artikel in Science, dass 89 % der Rechenleistung in großen Rechenzentren erbracht wird. Diese großen Rechenzentren verwenden maßgeschneiderte Chips, Speicher mit hoher Dichte, sogenannte Virtual-Machine-Software, ultraschnelle Netzwerke und spezielle Belüftungssysteme. Außerdem können sie an idealeren Standorten für große Rechencluster gebaut werden, z. B. in der Nähe von Seen oder in kühleren Regionen für eine kostengünstigere, effizientere Kühlung.

Die beabsichtigten (Neben-)Effekte der Ablösung von kleinen Rechenzentren vor Ort („on-prem“) durch größere, effizientere, cloudbasierte Lösungen hatten bisher einen relativ geringen Netto-Effekt. Die Verfügbarkeit dieser Ressourcen hat mehr und komplexere Forschung ermöglicht und damit die Nachfrage erhöht. Wenn die aktuelle Entwicklung hin zu immer größeren KI-Modellen anhält, wird der Ressourcenverbrauch von KI-Systemen jeden Effizienzgewinn übersteigen.

Wie versuchen wir bei Arabesque AI, diese Probleme zu lösen? Einer unserer Grundwerte als Unternehmen ist Nachhaltigkeit. Das erstreckt sich auch auf unsere Modelle. Wir sind von einem früheren On-Prem-System zu unserem Cloud-Partner Google Cloud Platform umgezogen, um Effizienzvorteile zu erzielen. Wir arbeiten intensiv daran, die Effizienz unserer Modelle zu erhöhen. Für unsere Forschungs- und Entwicklungsteams ist dies ein wichtiges Ziel für 2021. Unsere Modelle sind zwar äußerst komplex, aber das wird auch so bleiben und wahrscheinlich sogar noch zunehmen. Wir sind der Meinung, dass wir noch mehr an der Effizienz der von uns genutzten Rechenprozesse arbeiten können. Das wird sowohl ökologische als auch offensichtliche ökonomische Vorteile mit sich bringen. Wir bestärken andere Unternehmen, die auf Machine Learning und KI angewiesen sind, sich ebenfalls auf diese Ziele zu konzentrieren.